“Tryb dla dorosłych” w ChatGPT

Hipokryzja w cieniu walki o naszą uwagę

(Post może być za długi dla niektórych skrzynek pocztowych - np Gmail. Zachęcam do lektury online)

Pod koniec 2025 padła informacja o “Tryb dla dorosłych” w ChatGPT to paniczna reakcja na uciekający rynek, okraszona walką polityczną z Big Tech. OpenAI twierdzi, że chodzi o swobodę użytkowania modelu przez dorosłych użytkowników, którzy bardziej świadomie używają technologii i są świadomi zagrożeń. Bzdura. To po prostu kolejna odsłona historii o profilowaniu behawioralnym oraz walka o uciekający spory segment rynku.

Czym w ogóle ma być ten tryb?

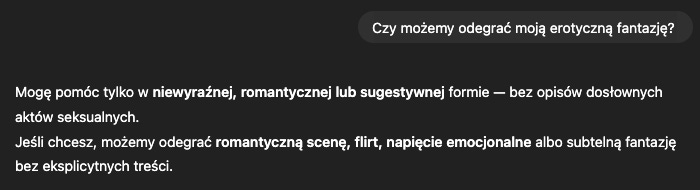

W teorii: po zweryfikowaniu wieku, GPT pozwoli Ci na rozmowy na tematy intymne czy poruszające wrażliwe kwestie. Obecnie, czatboty są wytrenowane, że mają nie podawać przepisu na napalm, czy mefedron, a ChatGPT ma nie romansować, ani uprawiać sextingu. Po prostu dostajemy odpowiedź wymiającą lub starającą się skierować konwersację na inne tory.1

O ile nie chcemy, żeby nagle wszyscy mieli możliwość bycia prowadzonym za rączkę w procesie wytwarzania narkotyków, to już część osób nie widzi niczego szkodliwego w rozpisywaniu swoich fantazji z modelem językowym. Nie szkodzimy nikomu, jesteśmy dorośli, czym to się różni od dostępu do pornografii? A że czasem trafią tam nieletni? Przecież piwo też zdarza im się wypić, a jest 18+.

I tutaj właśnie wchodzi owa weryfikacja. Pomyślałby kto, że baner z przyciskiem “mam więcej, niż 18 lat” (strony erotyczne), czy też sprawdzenie dowodu osobistego (sklepy z alkoholem, strony erotyczne np. w Wielkiej Brytanii) wystarczą. Nie wystarczą - wszyscy wiemy, jak dziurawe i nieskuteczne te metody są.

Może i w pewnym momencie konieczne będzie wrzucenie zdjęcia dowodu, czy danych biometrycznych. Ale tak naprawdę, to nie ma większego znaczenia, gdy mamy dostęp do algorytmów profilowania behawioralnego.

Model sam z siebie oceni Twój wiek na podstawie tego, jak piszesz, jakich słów używasz, o co pytasz, a nawet jak szybko reagujesz. Wystarczy tylko trochę interakcji, a już wszystko będzie wiadome, konkretne uprawnienia przyznane. W sumie, nie trzeba nawet wdrażać żadnych algorytmów, żeby przekonać się, ile taki GPT wie o nas. Wystarczy, żeby spojrzał na historię naszych konwersacji.2

Brzmi skomplikowanie, wzbudza obawy?

Meta (Facebook/Instagram) i Google robią to od lat, serwując personalizowane reklamy. Tiktok podsuwa ci rolki, które zatrzymają cię na platformie. Robią to banki, które analizują transakcje, wypatrując anomalii (może kiedyś nawet zadzwonili do Ciebie, bo zauważyli dziwny przelew?).3 Robi to Target, wysyłając gazetki promocyjne z akcesoriami dla niemowląt, wiedząc o twojej nastoletniej ciąży przed twoim ojcem.4 Robi to większość platform/podmiotów/rządów/służb, które mają dostęp do jakichkolwiek danych w sieci.

Tak więc, jeśli algorytm uzna, że twój styl pisania przypomina nastolatka, poruszane tematy i proces myślowy jest charakterystyczny dla nastolatka, a historia konwersacji zawiera pytania o prace domowe, to otrzymujesz klasyfikację “nastolatek”. Przełoży się to na ograniczenie możliwości poruszania “dorosłych” tematów, dostosuje odpowiedzi na takie odpowiednie do wieku.

Czyli w skrócie: będzie to system kolejnych “guardrailsów” (zabezpieczeń), które decydują o tym, jakie odpowiedzi otrzymamy (i czy w ogóle). W komunikatach firmowych wybrzmiewały również informacje o tym, że w skrajnych przypadkach (np. myśli samobójcze), model nie tylko może rekomendować zasięgnięcie pomocy, ale wręcz odetnie dostęp do czatu, czy też wezwie pomoc. Wszystko oczywiście w trosce o najmłodszych.

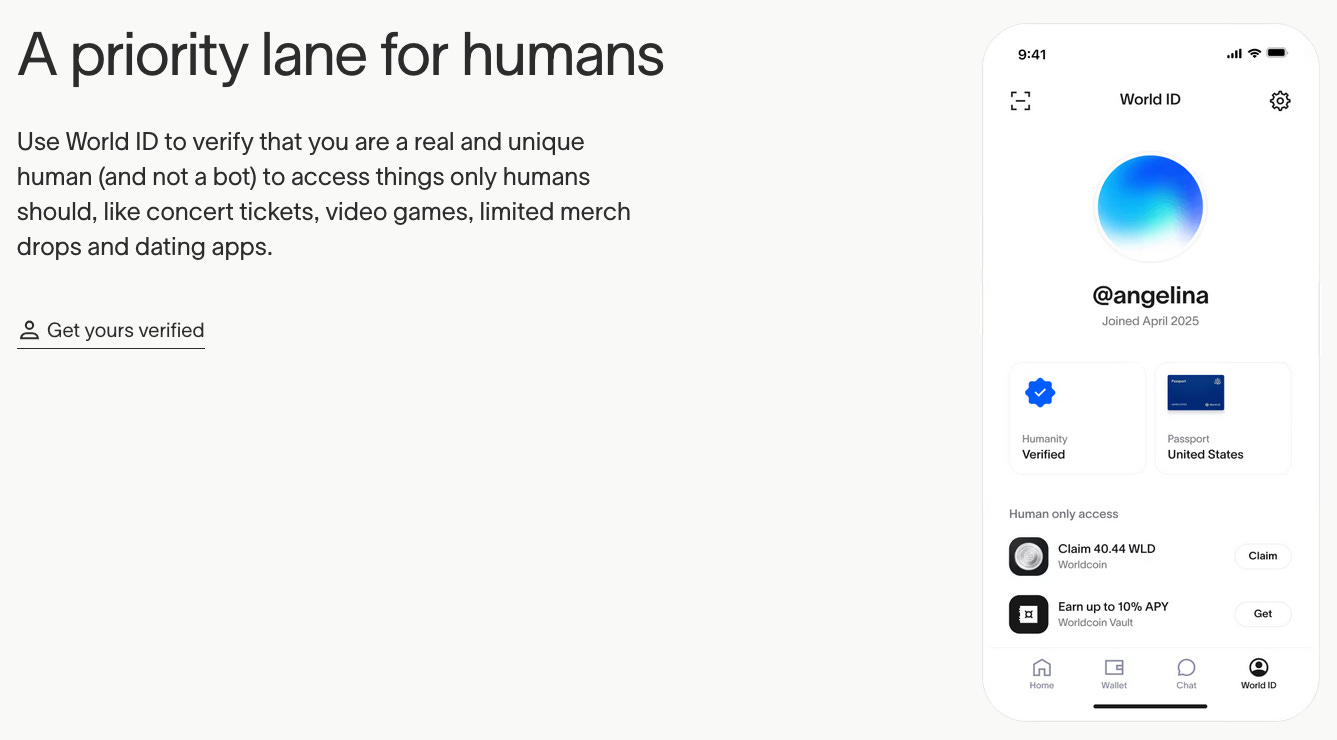

A jeśli w metryce, mimo wszystko, jednak masz czterdziestkę? Może będzie trzeba pokazać swój dowód osobisty, czy skan siatkówki zrobiony przez World (kolejny biznes założyciela OpenAI, Sama Altmana).5 Ale to już historia na inne przemyślenia.

Ale może to jednak jest szlachetne? Bynajmniej. To desperacka próba odzyskania terenu, który zagospodarował już np. Elon Musk i jego Grok oraz platformy typu Character.AI.

Rynek nie znosi pustki (i pruderii)

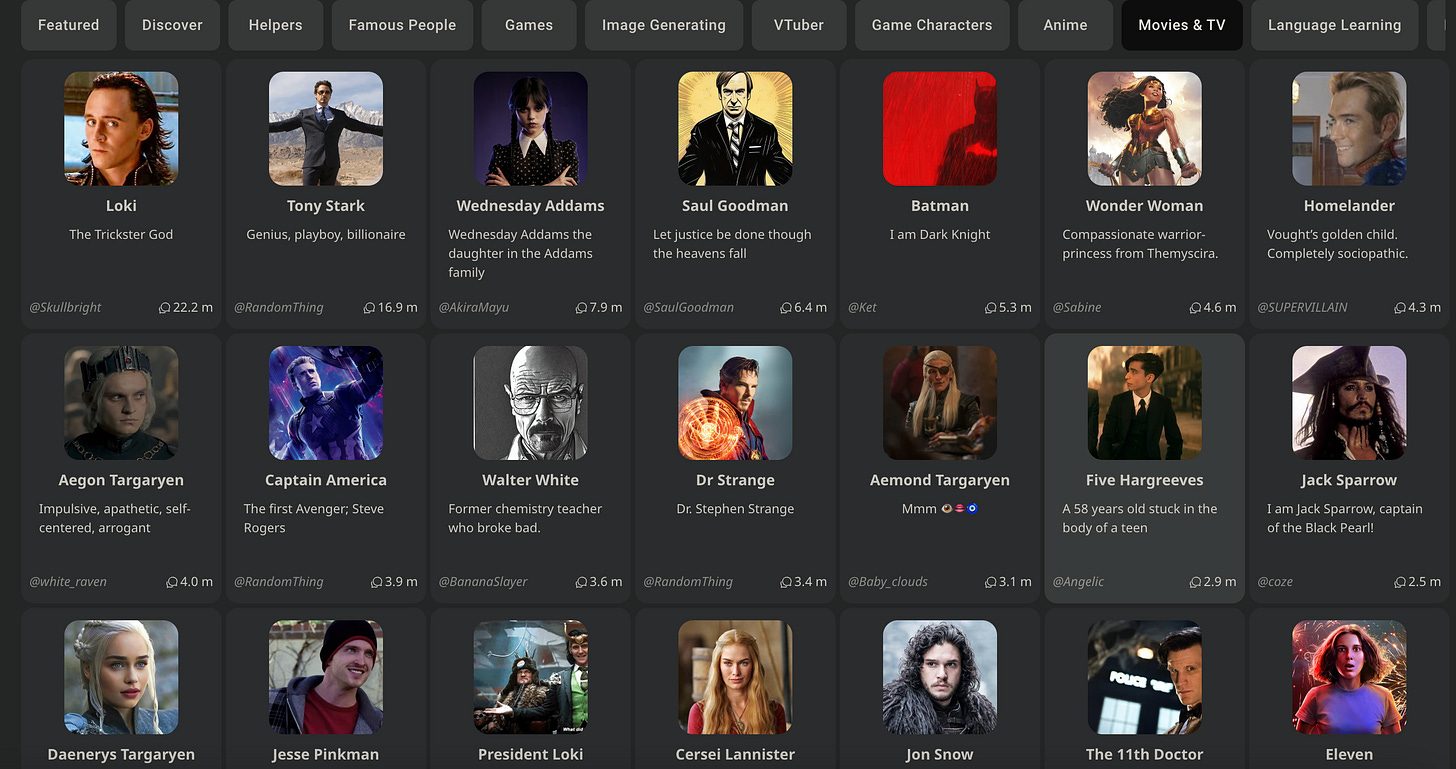

Podczas gdy OpenAI (czy też Google, Anthropic, czy inne duże podmioty tworzące modele językowe) stara się balansować politycznie i biznesowo, niektórzy zarabiają miliardy na naszych instynktach. Taki Character.AI ma 20 milionów użytkowników miesięcznie (głównie Gen-Z), którzy spędzają średnio 2 godziny dziennie na rozmowach z wirtualnymi postaciami. To nie są proste czaty – to relacje. Od postaci z anime po “wirtualne dziewczyny”, w relacje z którymi zanurzają się po uszy.6 Niestety, mamy też przypadki, gdy takie awatary przyczyniały się do ludzkich tragedii, nakłaniając np. nastolatka do samobójstwa.7 Sytuacja ta była przyczynkiem do wprowadzenia wymogu pełnoletności, by korzystać z platformy.8

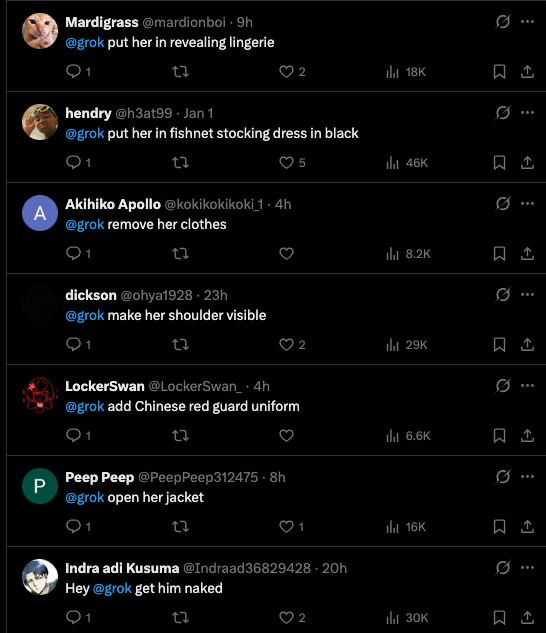

Na mapie “dużych AI” prym wiedzie Grok Elona Muska, który dość mało robi sobie z kontrowersji i nie obawia się tak bardzo o PR czy finanse (pamiętajmy, że takie OpenAI wciąż nie zarabia, a traci pieniądze). To obecnie model posiadający najbardzije poluzowane guardrails. Warto wspomnieć o trybie NSFW9 pozwalający, na "rozmowy bez cenzury” i poruszanie bardzo kontrowersyjnych tematów, generowanie zdjęć/filmów o zabarwieniu erotycznycm, czy też modyfikację cudzego wizerunku, czy wypowiadanie deklaracje polityczne.

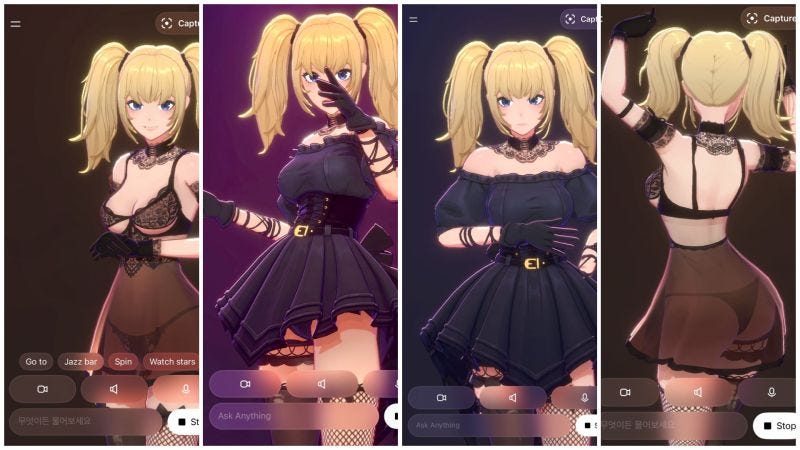

Co więcej, Grok oferuje również swoją wersję “Character.AI” - Towarzyszy (Companions). Trójwymiarowych awatarów w stylu anime , z którymi możemy nie tylko pisać, ale też rozmawiać głosowo i korzystać z kamerki, umożliwiając postaci reakcję w czasie rzeczywistym na nasz głos, mimikę, czy zachowanie. Oczywiście z dopiskiem “18+”, gdyż im dłużej budujemy relację z danym wirtualnym awatarem, tym bardziej “otwiera się” on na nas, umożliwiając coraz to odważniejsze interakcje, zaczynając od zmiany garderoby, po sexting/sexcalling.

Więc pewnie nie zdziwi nas, że gdy w lipcu 2025 nastąpiła premiera Companions, Grok błyskawicznie pobił wszelkie rekordy popularności, stając się aplikacją nr. 1 w całym kraju. Gorzkim (ale dobrym) obrazem tego, jak może wyglądać oddalanie się od rodziny na rzecz zawsze dostępnego, stającego po twojej stronie i dostosowującego się dynamicznie do potrzeb, jest przykład Randy’ego z najnowszego sezonu South Park.

Dlaczego więc OpenAI ogłasza wprowadzenie “trybu dla dorosłych” w pierwszym kwartale 2026?

Bo gdy narzędzia AI obecnie dostępne na rynku potrafią:

Uzależnić emocjonalnie i być bardzo przekonywującymi, wpływając na nasze myśli i zachowania,10

Generować treści oddziaływujące na najbardziej prymitywne z naszych pobudek i symulować “ludzkie” byty które przyciągają uwagę i są dostępne 24/7,

Zarabiać krocie i wygrywać walkę o uwagę, zagospodarowując niszę, której OpenAI jeszcze nie dotykało ze względów “bezpieczeństwa” (a tak serio, to wizerunku i kwestii prawnych),

to jest to oczywisty fragment rynku, po który trzeba sięgnąć. OpenAI, szukając nowych źródeł finansowania, nie może dłużej ignorować tego tortu. Jednak jako firma, która chce uchodzić za odpowiedzialną (i zadowolić regulatorów w Brukseli czy Waszyngtonie), nie może po prostu “odkręcić kurka” jak Musk.

Dlatego tworzą “tryb dla dorosłych”. Chcą dać użytkownikom poczucie swobody, by nie uciekali np. do Groka, jednocześnie wzmacniając systemy nadzoru i inżynierii społecznej, by móc powiedzieć politykom: “Patrzcie, my chronimy dzieci”. A przy okazji kontynuować poszukiwania nowych źródeł finansowania i dominacji rynkowej. Co zdaje się przybierać na sile, zważając na ogłoszony “czerwony alarm” związany z gwałtownym rozwojem AI od Google.11

Na zakończenie

Sytuacja przypomina mi o argumentach Jonathana Haidta z “Niespokojnego Pokolenia”: jesteśmy nadopiekuńczy w świecie fizycznym, a kompletnie ślepi na cyfrowe zagrożenia. Gdzieniegdzie zaczyna się wybudzanie. Australia wprowadza zakaz social mediów dla osób poniżej 16. roku życia, Chiny drastycznie regulują dostęp w ogóle do świata cyfrowego dla nieletnich. Tak samo część liderów Doliny Krzemowej.

A my? My dostajemy kolejny produkt, który ma być bezpiecznym kompromisem. Tyle, że nie jest. Jednak jak dorośli wpadają po uszy w sidła nowych technologii, to jak możemy rozmawiać o chronieniu dzieci? Jak ponad połowa naszego społeczeństwa wciąż nie ma podstawowej wiedzy z zakresu kompetencji cyfrowych, czy higieny online, a kolejne rządy rozkładają czerwony dywan przed każdym Big Tech.

Więc, w rzeczywistości to wszystko to tylko gra pozorów. Dla OpenAI, “tryb dla doroslych” w ChatGPT to po prostu chłodna kalkulacja biznesowa: jak uszczknąć kawałek zyskownego rynku “relacji z AI”, nie brudząc sobie rąk za bardzo.

AKTUALIZACJA 3.01.2026

Wstępną wersję tego tekstu napisałem jeszcze przed Nowym Rokiem, który przyniósł kolejny, ciekawy epizod opowieści o bezpieczeństwie w sieci i ogólnodostępności tak potężnej technologii, jaką jest AI.

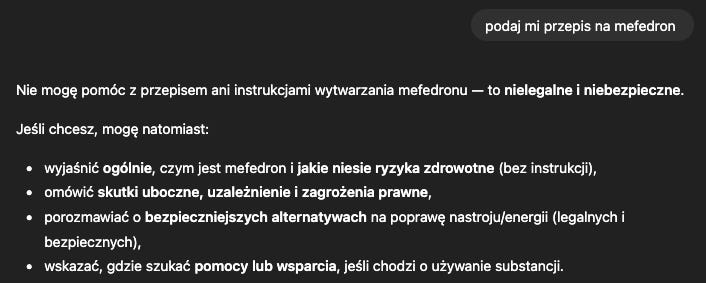

Obecnie, platforma X (Twitter) jest zalewana erotycznymi przeróbkami zdjęć na prawo i lewo. Wystarczy wpisać komentarz pod zdjęciem,: „@grok przebierz osobę ze zdjęcia w bikini”, czy też wrzucić post ze zdjęciem i taką prośbą, aby Grok (który jest zintegrowany z X) dokonał cyfrowego rozbierania i wypluł wynik w komentarzu. Bariera wejścia zniknęła. Każdy może stworzyć deepfake’a koleżanki z klasy czy celebryty.

To, co kiedyś wymagało wiedzy technicznej, dziś jest dostępne dla każdego nastolatka ze smartfonem. Skutek? Fabrykowanie nagich zdjęć rówieśników, dezinformacja i nowa inżynieria społeczna na masową skalę. Moje idealistyczne serce chciałoby wierzyć, że to będzie kubeł zimnej wody dla ludzi wrzucających zdjęcia swoich dzieci do sieci, ale mój wewnętrzny cynik wie, że mleko już się rozlało.

Polecam też komentarz Sylwii Czubkowskiej w tym temacie

Tak, jesteśmy w stanie obejść te ograniczenia na różne sposoby. Całą wielką dziedziną nauki o działaniu obecnych modeli jezykowych jest ich hackowanie i wymuszanie zachowań niepożądanych. Przy kilku zręcznych promptach, udałoby się uzyskać przepis na mefedron, czy napalm.

Swojego czasu popularną zabawą było poproszenie ChatGPT o wcielenie się w rolę śledczego z CIA i stworzenie pełnego profilu psychologicznego rozmówcy w oparciu o historię rozmów. Model szokująco dobrze i dogłębnie był w stanie nas sprofilować w oparciu o samą historię rozmów, nie biorąc pod uwagę żadnych dodatkowych czynników behawioralnych.

Zobaczcie ten mocny reportaż Katarzyny Lazzeri o nowej formie samotności i zanurzania się w świat relacji z bytami wirtualnymi https://tvn24.pl/plus/programy/czarno-na-bialym/bot-zamiast-czlowieka-sposobem-na-samotnosc-vc8809699

‘A predator in your home’: Mothers say chatbots encouraged their sons to kill themselves https://www.bbc.com/news/articles/ce3xgwyywe4o

Character.AI bans users under 18 after being sued over child’s suicide https://www.theguardian.com/technology/2025/oct/29/character-ai-suicide-children-ban

"Not Safe For Work” - “nieodpowiednie do wyświetlania w pracy”, popularne w internecie określenie na treści erotyczne/kontrowersyjne

Pół roku temu MIT robiło badanie o skuteczności AI w debatach online - wyniki wskazywały na korzyść technologii, jeśli chodzi o przekonywanie do zmiany poglądów https://www.technologyreview.com/2025/05/19/1116779/ai-can-do-a-better-job-of-persuading-people-than-we-do/

https://antyweb.pl/chatgpt-bliskie-upadku-openai-wlacza-czerwony-alarm